История алгоритмов пессимизации поисковой системы Google

Алгоритмы пессимизации Google – это санкции, накладываемые на веб-сайты в автоматическом режиме. Диагностика «ручных» санкций довольна простая – нужно зайти в Google Search Console и просмотреть уведомления от системы в разделе «Меры, принятые вручную». А вот с автоматическими «штрафами» дело обстоит немного сложнее. Если таковые сообщения отсутствуют, а трафик и места в поисковой выдаче существенно упали или ресурс был исключён из индекса, возможно, вы попали под влияние какого-либо из алгоритмов Google.

Зачастую, для диагностирования автоматических мер веб-мастера сравнивают время падения позиций ресурса в поисковой выдаче с выходом нового или обновлением действующего алгоритма. Отмечу, что колебания позиций ресурса и численность трафика могут зависеть не только от пессимизации, но и от многих других факторов, например, сезонность, появление сильного конкурента, технические ошибки и т.д.

Причины пессимизации сайтов поисковиком Google

К сожалению, поисковая система не сообщает о наложении алгоритмов пессимизации, соответственно, веб-мастерам приходится искать проблему самостоятельно. Из основных причин, по которым пессимизируются сайты, можно выделить:

- Низкое качество контента – авто сгенерированные тексты, отсутствие информативных и полезных для пользователей статей, скопированные у конкурентов тексты.

- «Чёрное или серое» SEO – использование на ресурсе скрытого текста/скрытых ссылок, дорвеев и т.п.

- Загрузка веб-страниц, на которых размещены нерелевантные ключевые слова, автозапросы в Google.

- Размещение на ресурсе контента или ПО, которые влекут за собой незаконную манипуляцию действиями пользователей, например, загрузка файлов на ПК без их согласия.

- Ссылочный спам – резкое увеличение числа ссылок, направляющих пользователей на ваш веб-сайт; слишком большой объём ссылок, ведущих пользователей с низкокачественного ресурса на ваш сайт.

- Взлом веб-сайта, изменение и добавление контента злоумышленниками.

Хронология алгоритмов пессимизации Google

На самом деле, поисковая система довольно часто обновляет актуальные алгоритмы и внедряет новые. Какие-то из них не были ощутимы для владельцев сайтов и веб-мастеров, поэтому о них практически нет информации. А вот некоторые вызвали массу проблем и дебатов в интернет пространстве, так как доставили немало проблем даже топовым ресурсам, значительно понизив их в результатах выдачи.

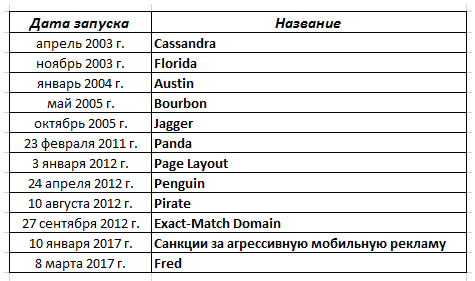

Итак, для начала я сведу самые значимые алгоритмы пессимизации поисковой системы Google в таблицу, а далее рассмотрю подробнее каждый из них в отдельности.

Алгоритм Cassandra: апрель 2003 г.

Данный алгоритм наложил санкции на ресурсы, на которых размещался скрытый текст и скрытые ссылки.

Алгоритм Florida: ноябрь 2003 г.

С внедрением данного алгоритма потеряли свои позиции ресурсы, которые были переполнены ключевыми словами. Под санкции попали веб-сайты с неуникальным и копированным у конкурентов контентом, купленным ссылочным профилем. Именно в этот период меняется отношение к SEO, выдвигаются новые требования поисковика к качеству текстов.

Алгоритм Austin: январь 2004 г.

Этот алгоритм стал своеобразным дополнением Florida. Поисковая система ещё больше ужесточила методы борьбы с переспамом и скрытым текстом, которые вводили в заблуждение поисковых роботов.

Алгоритм Bourbon: май 2005 г.

Согласно комментариям представителей Google, произошло ряд изменений в поиске. Однако мало кто из владельцев сайтов это почувствовал. Некоторые веб-мастера выразили предположение, что санкции от поисковика получили ресурсы с дублями контента.

Алгоритм Jagger: октябрь 2005 г.

В большей степени обновления коснулись низкокачественных ссылок. Поисковая система накладывала санкции на ресурсы с сомнительными и покупными ссылками, на «фермы» ссылок и веб-сайты, которые обменивались взаимными ссылками.

Алгоритм Panda: 23.02.2011 г.

Цель создания данного алгоритма – понижение позиций ресурсов с контентом низкого качества в поисковой выдаче. Проще говоря, этот алгоритм сортирует веб-сайты на качественные и низкокачественные, анализируя при этом:

- уникальность текстов на отдельной странице и на всём веб-сайте;

- наличие дублей текстов на разных веб-страницах одного сайта;

- ошибки в тексте – орфографические, стилистические, грамматические;

- соответствие рекламных объявлений к содержимому страниц, включая количество рекламы;

- численность ключевых слов, качество входящих/исходящих ссылок;

- действия интернет-пользователей – время пребывания на сайте, число просматриваемых страниц, количество отказов и т.д.

Первое время Panda не входил в комплекс мер основного алгоритма поисковой системы, работая в качестве отдельного фильтра и воздействуя на определённое число ресурсов при каждом своём обновлении. Позже (в начале 2016 г.) он вошёл в основной алгоритм. В результате обновления Panda стали проходить очень часто, поэтому представители поисковой системы больше не анонсируют очередные апдейты.

Алгоритм Page Layout: 03.01.2012 г.

Незначительное дополнение к нашумевшему Panda – алгоритм создан для мониторинга удобства просмотра страниц интернет-пользователями. Под санкции попали ресурсы с излишней рекламой, которая располагалась на большей части экрана персонального компьютера, закрывая основной контент.

Алгоритм Penguin: 24.04.2012 г.

Задача этого алгоритма – понижение позиций ресурсов со спамными ссылочными профилями, а также веб-сайтов, которые манипулируют ссылочной массой. До октября 2016 г. алгоритм обновлялся с определённой периодичностью, после этого момента он стал работать в режиме реального времени.

С выходом Penguin была начата борьба поисковика с ресурсами, которые набирали авторитетность путём закупки обратных ссылок. Алгоритм может понижать весь веб-сайт в результатах выдачи, даже есть вероятность его исключения из поиска.

Алгоритм Pirate: 10.08.2012 г.

Его задача – снижение позиций веб-сайтов, на которые поступают жалобы за нарушение авторских прав. У поисковика есть специальная форма, при помощи которой правообладатель может направить свою жалобу. Под санкции Pirate попали ресурсы с размещённым пиратским контентом или сведениями о том, как получить его, не обращаясь к правообладателю.

Пессимизации подверглись веб-сайты с фильмами, музыкой, книгами, которые пользователь мог скачать или посмотреть. Поисковая система также пессимизировала торрент-трекеры, агрегаторы ссылок на файлообменники. Конечно же, представители Google не озвучивают, сколько должно поступить жалоб для наложения санкций.

Алгоритм Exact-Match Domain (EMD): 27.09.2012 г.

Алгоритм понижает ресурсы низкого качества, которые оптимизированы под один запрос, являющийся доменом. Например, под пессимизацию, скорее всего, попадёт веб-сайт kupi-slona.ru, все страницы которого оптимизированы под запрос «купи слона».

Санкции за агрессивную мобильную рекламу: 10.01.2017 г.

Поисковая система сообщила, что будет наказывать ресурсы с агрессивной рекламой, в частности, со всплывающими окнами, которые мешают мобильным пользователям получать доступ к содержимому страниц.

Алгоритм Fred: 08.03.2017 г.

Понижает сайты, которые нацелены на получение прибыли от размещения рекламных объявлений и ссылок, направляющих на другие веб-ресурсы. Представители поисковой системы пояснили, что под санкции попадают сайты, действующие наперекор рекомендациям Google для веб-мастеров. Весьма размытое толкование, не правда ли?

А вот SEO-оптимизаторы поделились своими наблюдениями на просторах интернета. Подытожив многочисленные комментарии, можно сделать вывод, что под санкции Fred попадают ресурсы:

- с переизбытком рекламы, например, баннеры popunder, всплывающие окна pop up и т.п.;

- с большим объёмом исходящих ссылок;

- с контентом, созданным для поисковых роботов с целью генерирования трафика.